Neugestaltung der Kundenerfahrung für Unternehmen der MCP-Generation

Die Regeln von KI schreiben sich fast täglich neu. Menschen und Marken bemühen sich eifrig darum, zu definieren, was KI bedeutet und wie sie funktioniert. Dabei steht jedoch eine Frage über allen anderen: Wer kontrolliert die Zukunft Ihrer Kunden- und Mitarbeitererfahrungen – Sie oder Ihre Lieferanten? Wir bei Avaya glauben, dass Sie das sein sollten. Deshalb setzen wir auf die offene Zukunft der KI und entwickeln die Avaya Infinity-platform zur Unterstützung des Model Context Protocol (MCP). Es ist der richtige Schritt – im Interesse unserer Kunden, des Marktes und all dessen, was künftig Vertrauen und Innovation in Unternehmen und im öffentlichen Sektor ausmacht

Was ist MCP?

MCP steht für Model Context Protocol, einen neuen offenen Standard, der es KI-Modellen (wie GPT, Claude oder Gemini) ermöglicht, sicher und zuverlässig mit externen Tools, Datenquellen, APIs und dem Benutzerkontext auf strukturierte Weise zu interagieren. Dadurch kann KI mit Speicher, Relevanz und Kontinuität arbeiten – nicht isoliert, sondern synchron mit dem Unternehmenskontext, der Benutzerhistorie und den betrieblichen Absichten. MCP macht KI in risikoreichen und groß angelegten Umgebungen unendlich nützlich.

„Dies ist kein Moment zum ,Abwarten'. Avaya ist davon überzeugt, dass jetzt der richtige Zeitpunkt ist, um gezielt an der Entwicklung der maßgeblichen offenen Orchestrierungs-Engine für moderne Unternehmen zu arbeiten.“

David Funck, Chief Technology Officer, Avaya

Wie funktioniert MCP?

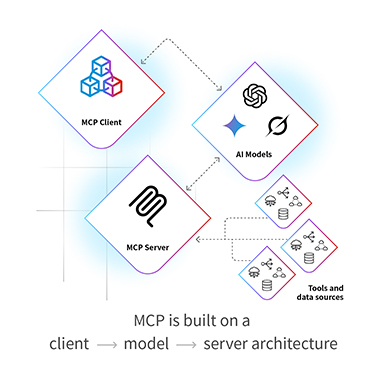

MCP basiert auf einer Client → Modell → Server-Architektur:

- Der Client sammelt Kontextinformationen (Benutzerinformationen, Rolle, Aufgabe, Umgebung).

- Das Modell (z. B. Claude, GPT) erhält den Kontext und eine Liste der verfügbaren Tools oder Aktionen.

- Der Server hostet die Tools (APIs, Datenbanken usw.) und führt alle vom Modell angeforderten Aktionen aus.

Die gesamte Kommunikation folgt strukturierten Schemata, sodass alles interpretierbar, nachvollziehbar und sicher ist.

Reibungsverluste mit KI und MCP beseitigen

Zu lange bedeutete die Integration von KI in die Kundenerfahrung, sich für das kleinere der zwei Übel zu entscheiden:

- Anbindung an das geschlossene Ökosystem eines einzelnen Anbieters, wodurch Flexibilität und zukünftige Optionen eingeschränkt werden

- Chaos durch fragile, kostspielige, einmalige Integrationen über mehrere Tools und Datensilos hinweg

Diese falsche Wahl schränkt Innovationen ein und belastet IT-Teams. Es entstehen fragmentierte Erfahrungen, die das Vertrauen sowohl der Kunden als auch der Mitarbeiter untergraben. In einer Welt, die sich mit der Geschwindigkeit der KI bewegt, ist dieser Ansatz einfach nicht tragbar.

Willkommen bei MCP – dem offenen, herstellerunabhängigen Standard, der alles verändert. Mit MCP können KI-Modelle nahtlos mit Tools, Daten und Betriebslogik interagieren – sicher und in großem Maßstab. Eine bevorzugte Metapher für die wenigen, die sich zu diesem Thema äußern, ist die Vorstellung von USB-C für KI: ein universeller Anschluss, der über Modelle, Plattformen und Unternehmenssysteme hinweg funktioniert.

Erstellt und veröffentlicht von Anthropic Ende 2024. Die schnelle Einführung von MCP durch große Technologieunternehmen wie OpenAI, Google DeepMind und Microsoft unterstreicht dessen strategische Bedeutung. Diese Ausrichtung zeigt, dass man sich gemeinsam bewusst geworden ist, dass proprietäre Integrationen das Marktwachstum verstärkt behindern als die Vorteile, die geschlossene Ökosysteme bieten. Wir erleben und gestalten derzeit einen grundlegenden Wandel hin zu Interoperabilität, Transparenz und Benutzerkontrolle.

MCP ermöglicht KI-Systemen den Betrieb mit dynamischem Bewusstsein für Benutzer, Sitzung und Geschäftskontext. Für Avaya Infinity bedeutet dies, dass Modelle konsistent Antworten liefern können, die nicht nur präzise, sondern auch relevant, personalisiert und markengerecht sind – selbst in fragmentierten Ökosystemen und auf Unternehmensebene. Dieses Maß an kontextbezogener Intelligenz ist für Unternehmen, die Tausende von Workflows, Benutzern und Integrationspunkten über alle Betriebsbereiche hinweg verwalten, von entscheidender Bedeutung.

Zusammenarbeit mit Databricks

Im Rahmen unserer Verpflichtung zu sicherer, skalierbarer und offener KI arbeiten wir mit Databricks zusammen, um die MCP Implementierung innerhalb der Avaya Infinity platform mit Governance und Datenschutz auf Unternehmensniveau auszustatten. Diese Zusammenarbeit stellt sicher, dass Unternehmenskunden KI-Tools mit detaillierter Zugriffskontrolle, Audit-Protokollierung und nahtloser Integration über strukturierte und unstrukturierte Datenquellen hinweg vertrauensvoll einsetzen können.

„Generative KI bietet ein enormes Potenzial bei der Veränderung von Kundenerfahrungen, und wir freuen uns sehr über die Zusammenarbeit mit Avaya, um Unternehmen dabei zu unterstützen, ihre Daten schnell zu vereinheitlichen, die Daten- und KI-Governance und -Sicherheit zu vereinfachen und letztendlich eine KI bereitzustellen, die ihr Geschäft versteht.“

Heather Akuiyibo, VP of GTM Integration, Databricks

Von Fragmentierung zu Gestaltungsspielraum mit MCP

In einem typischen Unternehmen gibt es eine „N“-Anzahl an Tools und Datenquellen (z. B. Salesforce, eine Produktdatenbank, eine Wissensdatenbank) und eine „M“-Anzahl an KI-Modellen oder Anwendungen, die darauf zugreifen müssen. Vor MCP erforderte die Verbindung jedes Tools mit jedem KI-Modell eine einzigartige Point-to-Point-Integration. Dies führte zu einer kombinatorischen Explosion der Entwicklungsarbeit, was eine Architektur zur Folge hatte, die teuer zu erstellen, schwer zu pflegen und von Natur aus nicht skalierbar war.

MCP verändert dieses Paradigma durch die Einführung einer standardisierten Zwischenschicht, die das komplexe N x M-Problem in eine einfache und skalierbare „N+M”-Lösung umwandelt. Jedes der „N“-Tools muss nur mit einem einzelnen MCP-Server verpackt werden, und jedes der „M“-KI-Modelle benötigt nur einen einzelnen MCP Client. Sobald eine Komponente MCP „spricht“, kann sie mit jeder anderen MCP-kompatiblen Komponente im Ökosystem kommunizieren. Das reduziert den Entwicklungsaufwand erheblich, beseitigt überflüssige Arbeiten und eliminiert die technischen Belastungen, die mit der Pflege zahlreicher anfälliger, individueller Konnektoren verbunden sind. Investitionen in neue Technologien, Kanäle und Modalitäten, die Kundeninteraktionen vereinheitlichen, führen oft zu einem Bruch. Kunden fühlen sich weniger wahrgenommen, weniger umsorgt und weniger mit den Unternehmen verbunden als je zuvor. Viele Unternehmen spüren diesen Schmerz am stärksten im Contact Center.

Avaya wendet das Blatt und vereinheitlicht die fragmentierte Contact-Center-Erfahrung. Durch die Verknüpfung von Kanälen, Erkenntnissen, Technologien und Workflows, die für erstklassige Interaktionen sorgen.

Der potenzielle ROI von MCP

Mit MCP profitieren Avaya Infinity Benutzer von einem noch höheren geschäftlichen Mehrwert: schnellere Problemlösungen, natürlichere Konversationen, stärkere Markenkonsistenz und höhere Zufriedenheit bei Interaktionen mit Kunden und Mitarbeitern. Es eröffnet eine neue Leistungsstufe in der generativen KI, wo die Ergebnisse nicht nur intelligent sind, sondern auch situationsbezogen und strategisch ausgerichtet.

Erste Untersuchungen deuten darauf hin, dass MCP für Unternehmen zu erheblichen Verbesserungen führt und in einer Reihe von Bereichen Zeit und Geld spart:

| Vor MCP | Nach MCP | |

| Integration | Benutzerdefinierte Konnektoren pro Modell/Tool | Eine MCP-Schnittstelle funktioniert modell- und werkzeugübergreifend |

| Bereitstellungszeit | Lang, teuer durch maßgeschneiderte Technik | 50–70 % schneller, niedrigere Kosten durch Wiederverwendung (quiq.com, Palma AI, Humanloop, aibase.com) |

| Datenzugriff | KI-blind gegenüber Systemdaten, Kontext verloren | Voller Echtzeitkontext: CMS, CRM, EHR, ERP |

| Risikomanagement | Manuelle Suche, verzögerte Betrugserkennung | Systemübergreifende Sofortprüfungen reduzieren Betrug um 30 % |

Die Zukunft ist offen

Die weltweit einflussreichsten KI-Führungskräfte schließen sich MCP an, weil sie erkennen, dass die Zukunft der KI offen und kontextabhängig ist und ihr Potenzial kaum zu überschätzen ist. Avaya ist stolz darauf, seine Überzeugung und seine Verpflichtung für eine offene und intelligente Orchestrierung fortzusetzen und eine Vorreiterrolle dabei zu übernehmen, MCP in die Welt der Kundenerfahrung zu bringen.

Glossar

Vollständiges Glossar der Begriffe finden Sie unten.

| Begriff | Definition | Warum es wichtig ist |

| MCP (Model Context Protocol) | Ein offenes Protokoll, das standardisiert, wie KI-Modelle über strukturierte Kontextobjekte mit Tools, APIs und Speicher interagieren. | Ermöglicht zuverlässiges, interpretierbares und skalierbares KI-Verhalten über Workflows und Unternehmenssysteme hinweg. |

| Kontext | Ein Bundle strukturierter Informationen, die an ein Modell weitergegeben werden – wie Benutzer-ID, Sitzungsverlauf, Rollen, Zeit oder Tool-Verfügbarkeit. | Befähigt Modelle, relevante, personalisierte und situationsbezogene Antworten zu generieren. |

| Modell | Die generative KI (z. B. Claude, GPT-4, Gemini), die den MCP-Kontext empfängt und Antworten generiert. | Das „Gehirn“ in der Schleife, das Kontext verwendet, um intelligentere, besser abgestimmte Entscheidungen zu treffen. |

| Client | Die Anwendung oder Schnittstelle (z. B. Chat-Fenster, Agenten-Framework, Kundenportal), die Kontext sammelt und an das Modell sendet. | Der benutzerseitige Einstiegspunkt, der Anfragen und Interaktionen initiiert. |

| Server | Die Logikschicht, die Tools, APIs, Funktionen und Datenquellen hostet, die das Modell über MCP verwenden kann. | Das Aktionsausführungs-Backend, das sicherstellt, dass KI-Ausgaben reale Geschäftsaktionen auslösen können. |

| Tools | Diskrete Funktionen oder APIs (z. B. „Wissensdatenbank suchen“, „Ticketstatus prüfen“, „CRM aktualisieren“), die dem Modell über MCP zugänglich gemacht werden. | Ermöglichen es Modellen, über die Sprache hinauszugehen und Aktionen auf externen Systemen auszuführen. |

| Schemata | Die strukturierten Definitionen (in JSON oder YAML) dafür, wie Tools und Kontext dargestellt und an Modelle weitergegeben werden sollten. | Erstellen Sie eine gemeinsame Sprache zwischen Client, Server und Modell, um Konsistenz und Debugging zu verbessern. |

| Arbeitsspeicher | Dauerhafter Kontext, der über Sitzungen hinweg beibehalten wird (Benutzerhistorie, Präferenzen, vergangene Aktionen) und dem Modell bereitgestellt wird. | Ermöglicht Kontinuität und Personalisierung im Laufe der Zeit – wie ein Agent, der sich an einen Kunden „erinnert“. |

| Kurzlebiger Kontext | Kurzlebige, sitzungsspezifische Informationen (z. B. aktuelle Aufgabe, temporäre Variablen). | Sorgt dafür, dass KI-Antworten nur für die aktuelle Interaktion fokussiert und effizient bleiben. |

| Agent | Ein KI-System, das Maßnahmen ergreifen, Tools aufrufen und Entscheidungen basierend auf dem MCP-Kontext treffen kann – häufig in autonomen oder halbautonomen Workflows verwendet. | MCP bildet das Rückgrat für ein sicheres, nützliches und steuerbares Agentenverhalten. |

| Orchestration | Koordinierung mehrerer Schritte, Tools und Modellergebnisse, um ein Geschäftsziel höherer Ordnung zu erreichen. | MCP vereinfacht die Orchestrierung, indem es Modellen Zugriff auf strukturierten Kontext und Tools in einem Protokoll gewährt. |

| Beobachtbarkeit | Die Fähigkeit, zu prüfen, welcher Kontext übergeben wurde, welche Entscheidungen das Modell getroffen hat und wie Tools verwendet wurden. | Entscheidend für Debugging, Compliance und Unternehmensvertrauen in KI-Systeme. |

| Interoperabilität | Die Fähigkeit verschiedener KI-Modelle und -Plattformen, mit einer gemeinsamen Struktur von Tools und Kontext zu arbeiten. | MCP ermöglicht Plug-and-Play-KI über verschiedene Anbieter und Architekturen hinweg. |